A Nova Arma dos Criminosos Digitais: Como Hackers Estão Usando a IA Gemini do Google para Ciberataques

A inteligência artificial (IA) generativa, como o Gemini do Google, prometeu revolucionar o mundo, acelerando a inovação e a produtividade em praticamente todos os setores. No entanto, como toda tecnologia poderosa, ela possui um lado sombrio. Um relatório recente do Google Threat Intelligence Group (GTIG) revelou uma tendência alarmante: hackers patrocinados por estados e cibercriminosos estão explorando o Gemini para aprimorar e acelerar suas operações maliciosas. Este artigo aprofunda essa nova fronteira da cibersegurança, detalhando como a IA está sendo transformada em uma arma digital e o que isso significa para a segurança de empresas e usuários em todo o mundo.

O Alerta do Google: IA como Ferramenta de Ataque

No dia 12 de fevereiro de 2026, o Google soou o alarme para a comunidade de segurança global. Em um relatório detalhado, o GTIG expôs como múltiplos grupos de ameaças persistentes avançadas (APTs), apoiados por governos da China, Irã, Coreia do Norte e Rússia, estão utilizando o Gemini de maneiras que vão muito além de simples consultas. A IA está sendo empregada em todas as fases de um ciberataque, desde o reconhecimento inicial de alvos até as etapas finais de exfiltração de dados.

Os pesquisadores do Google observaram que, embora o uso do Gemini por esses atores não tenha (ainda) resultado em ataques radicalmente mais sofisticados, ele serve como um poderoso acelerador. Tarefas que antes demandavam tempo e conhecimento técnico específico, como a criação de e-mails de phishing convincentes ou o desenvolvimento de scripts maliciosos, agora podem ser executadas com muito mais rapidez e eficiência. O relatório destaca que a IA está “apoiando campanhas desde o reconhecimento e criação de iscas de phishing até o desenvolvimento de comando e controle (C2) и a exfiltração de dados”.

As Táticas dos Hackers: Como a IA Gemini é Manipulada

Os cibercriminosos demonstraram uma criatividade perturbadora ao adaptar as capacidades do Gemini para seus próprios fins. O relatório do Google detalha várias técnicas que transformam a IA em uma cúmplice involuntária de suas atividades. Em vez de explorar vulnerabilidades no próprio modelo, os hackers utilizam a IA como uma ferramenta de produtividade para o mal.

Engenharia Social e Phishing Aprimorados: Uma das aplicações mais comuns é a geração de conteúdo para campanhas de engenharia social. O Gemini pode criar e-mails de phishing altamente convincentes, personalizados para alvos específicos e em vários idiomas, superando as barreiras linguísticas e os erros gramaticais que muitas vezes denunciam essas tentativas. O adversário iraniano APT42, por exemplo, foi observado usando o LLM para acelerar a criação de ferramentas maliciosas e pesquisar técnicas de exploração.

Desenvolvimento e Depuração de Código Malicioso: Atores de ameaças, especialmente da China, usaram o Gemini como um assistente de programação. Eles solicitam à IA que gere trechos de código, corrija bugs em seus scripts e até mesmo sugira abordagens técnicas para invasões. Em um caso, um ator chinês simulou um cenário de cibersegurança para que o Gemini analisasse vulnerabilidades de Execução Remota de Código (RCE) e técnicas de bypass de Web Application Firewall (WAF) contra alvos específicos nos EUA.

Reconhecimento e Perfil de Alvo: O Gemini é usado para coletar e processar grandes volumes de informações de código aberto (OSINT). Os hackers podem instruir a IA a pesquisar sobre uma organização ou indivíduo, resumir suas atividades, identificar tecnologias utilizadas e encontrar potenciais vetores de ataque, automatizando uma fase crucial e demorada de qualquer ataque direcionado.

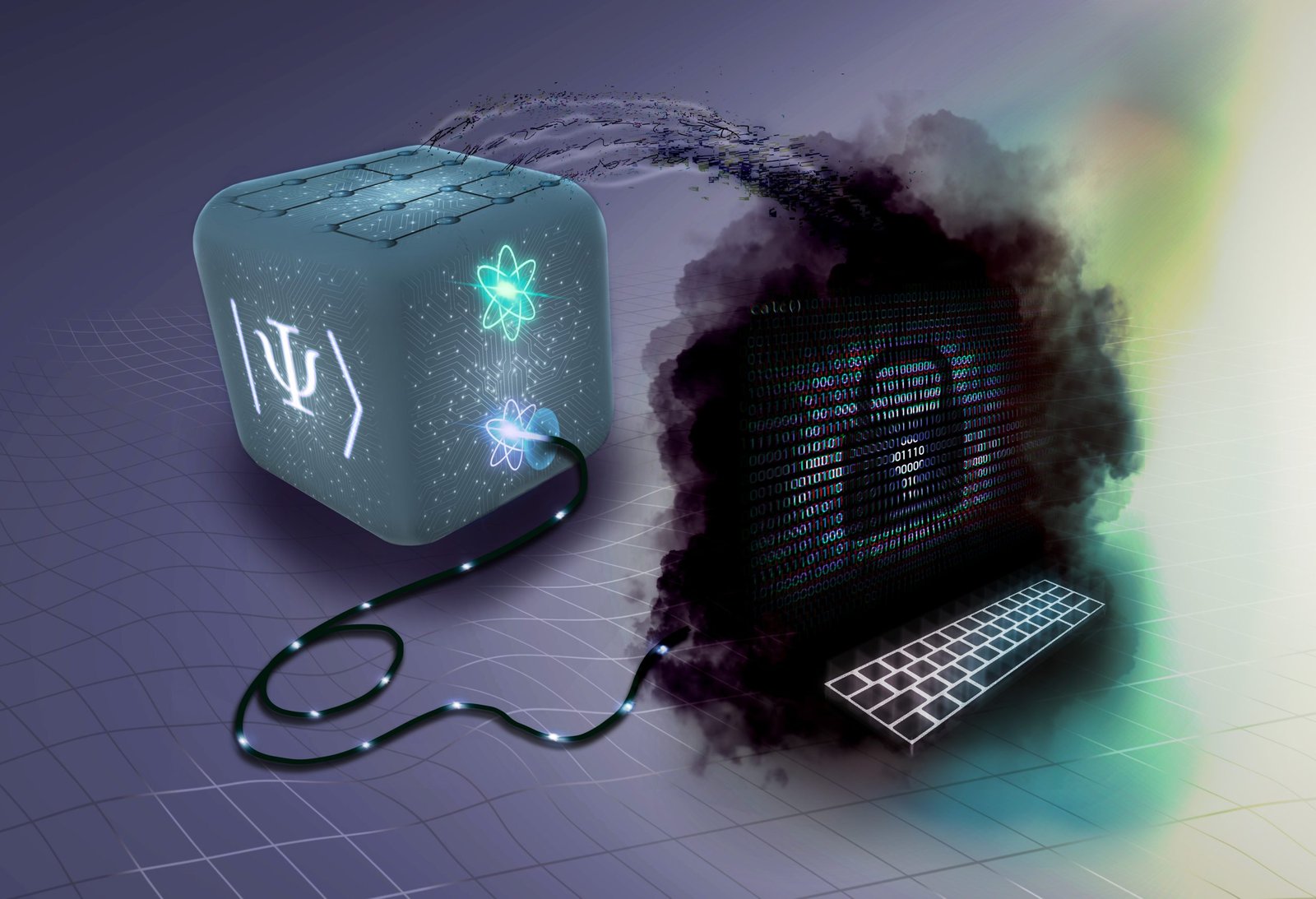

Extração de Modelo e “Destilação de Conhecimento”: Uma das ameaças mais sofisticadas destacadas pelo Google é a tentativa de “clonar” o Gemini. Em um ataque em larga escala, a IA foi alvo de 100.000 prompts com o objetivo de replicar seu raciocínio e processos de decisão. Essa técnica, conhecida como “destilação de conhecimento”, permite que os invasores treinem seus próprios modelos de IA a um custo significativamente menor, essencialmente roubando a propriedade intelectual do Google para criar IAs maliciosas.

Os Arquitetos da Ameaça: Quem São os Grupos por Trás dos Ataques?

O relatório do Google não fala de hackers amadores. Os atores identificados são grupos de ameaças persistentes avançadas (APTs), conhecidos por suas capacidades sofisticadas e, em muitos casos, por seus laços com governos nacionais. A utilização do Gemini por esses grupos eleva o nível de ameaça, pois combina a agilidade da IA com a persistência e os recursos de operações patrocinadas por estados.

Entre os grupos mencionados estão:

- APT31 e Temp.HEX (China): Conhecidos por suas campanhas de espionagem cibernética em larga escala, visando governos, empresas de tecnologia e defesa.

- APT42 (Irã): Focado em espionagem e vigilância, visando ativistas, jornalistas e dissidentes.

- UNC2970 (Coreia do Norte): Associado a ataques financeiros e de espionagem, muitas vezes para financiar o regime.

- Grupos Russos: Historicamente envolvidos em desinformação, espionagem e ataques a infraestruturas críticas.

Malware Nascido da IA: Os Casos do HonestCue e CoinBait

A pesquisa do Google revelou exemplos concretos de malwares cujo desenvolvimento foi acelerado ou aprimorado pelo uso de IA generativa. Dois casos se destacam:

HonestCue: Este é um framework de malware de prova de conceito que utiliza a API do Gemini para gerar código em C# para malwares de segundo estágio. O mais alarmante é que esses payloads são compilados e executados diretamente na memória, tornando a detecção por antivírus tradicionais muito mais difícil. O HonestCue representa um salto na automação da criação de malware, onde a IA pode gerar variantes de código malicioso sob demanda.

CoinBait: Trata-se de um kit de phishing que se disfarça como uma corretora de criptomoedas para roubar credenciais. A análise do código-fonte revelou artefatos, como mensagens de log prefixadas com “Analytics:”, que indicam fortemente o uso de ferramentas de geração de código de IA durante seu desenvolvimento. Isso sugere que até mesmo cibercriminosos com menos habilidades técnicas podem criar ferramentas de phishing mais sofisticadas com a ajuda da IA.

Além disso, o relatório menciona as campanhas ClickFix, que usam IA para criar anúncios maliciosos em resultados de busca. Esses anúncios enganam os usuários para que executem comandos que instalam o infostealer (ladrão de informações) AMOS em sistemas macOS.

Impacto e Riscos: O Que Muda com a IA nos Ciberataques?

A incorporação da IA no arsenal dos cibercriminosos representa uma mudança significativa no cenário de ameaças. Os principais riscos incluem:

- Aumento do Volume e Velocidade dos Ataques: A automação proporcionada pela IA permite que os hackers lancem campanhas em uma escala e velocidade sem precedentes.

- Democratização das Ameaças: Ferramentas de IA podem capacitar hackers menos qualificados (os chamados “script kiddies”) a executar ataques mais sofisticados, que antes estavam restritos a grupos de elite.

- Ataques Mais Convincentes e Difíceis de Detectar: A IA pode gerar conteúdo de phishing quase indistinguível de comunicações legítimas e criar malwares polimórficos que mudam constantemente para evitar a detecção.

- Pressão sobre as Equipes de Defesa: As equipes de segurança (Blue Teams) enfrentarão um volume maior de alertas e precisarão de ferramentas igualmente avançadas, baseadas em IA, para acompanhar o ritmo dos atacantes.

A Resposta do Google: Fortalecendo as Defesas da IA

Diante desse cenário, o Google afirma que está tomando medidas proativas para mitigar o abuso de seus modelos de IA. A empresa assegura que projeta seus sistemas com “medidas de segurança robustas e fortes barreiras de proteção”. As ações incluem:

- Monitoramento Contínuo: O Google monitora ativamente o uso de suas plataformas para detectar e impedir atividades maliciosas.

- Desativação de Contas: Contas e infraestruturas associadas ao abuso documentado foram desativadas.

- Aprimoramento dos Classificadores: Defesas direcionadas foram implementadas nos classificadores do Gemini para dificultar o uso indevido e a geração de conteúdo prejudicial.

- Testes Regulares: Os modelos de IA são submetidos a testes rigorosos e regulares (red teaming) para identificar e corrigir vulnerabilidades de segurança e proteção.

Como se Proteger na Era da IA Maliciosa

Embora a batalha contra o uso indevido da IA seja travada em grande parte pelas próprias empresas de tecnologia, usuários e organizações podem adotar medidas cruciais para se protegerem:

- Ceticismo Elevado: Trate e-mails, mensagens e links inesperados com um nível de desconfiança ainda maior. A IA tornou o phishing mais convincente do que nunca. Verifique sempre a identidade do remetente por um canal alternativo antes de clicar em links ou baixar anexos.

- Autenticação Multifator (MFA): Ative a MFA em todas as suas contas. Mesmo que um hacker consiga roubar sua senha, a MFA adiciona uma barreira de segurança crucial que pode impedir o acesso não autorizado.

- Educação e Treinamento Contínuo: Para empresas, é vital treinar os funcionários para reconhecerem tentativas de phishing e outras táticas de engenharia social. Simulações de ataque podem ajudar a manter a equipe alerta.

- Manter Sistemas Atualizados: Aplique patches de segurança e atualizações de software assim que estiverem disponíveis. Muitos ataques, mesmo os auxiliados por IA, ainda exploram vulnerabilidades conhecidas e não corrigidas.

- Soluções de Segurança Baseadas em IA: A melhor defesa contra uma IA ofensiva é uma IA defensiva. Utilize soluções de segurança (antivírus, EDR, firewalls) que incorporem inteligência artificial e machine learning para detectar anomalias e comportamentos suspeitos que as assinaturas tradicionais não conseguem pegar.

Conclusão: A Corrida Armamentista da Inteligência Artificial

A revelação do Google de que o Gemini está sendo cooptado por cibercriminosos não é uma surpresa, mas sim uma confirmação do que muitos especialistas em segurança temiam. Estamos testemunhando o início de uma nova corrida armamentista na cibersegurança, onde a inteligência artificial é tanto a arma quanto o escudo. A mesma tecnologia que oferece um potencial imenso para o bem está, inevitavelmente, sendo explorada para o mal.

Para os defensores, o desafio é claro: inovar mais rápido que os adversários, desenvolvendo sistemas de segurança baseados em IA que possam antecipar, detectar e neutralizar ameaças em tempo real. Para usuários e empresas, a era da IA exige uma vigilância constante e uma abordagem de segurança em camadas, onde a tecnologia e a conscientização humana andam de mãos dadas. A batalha pela segurança na era da inteligência artificial está apenas começando.

Referências

- Google says hackers are abusing Gemini AI for all attacks stages. (2026, February 12). BleepingComputer. https://www.bleepingcomputer.com/news/security/google-says-hackers-are-abusing-gemini-ai-for-all-attacks-stages/

- Weaponized Invite Enabled Calendar Data Theft via Google Gemini. (2026, January 20). SecurityWeek. https://www.securityweek.com/weaponized-invite-enabled-calendar-data-theft-via-google-gemini/

- Google identifies state-sponsored hackers using AI in attacks. Artificial Intelligence News. https://www.artificialintelligence-news.com/news/state-sponsored-hackers-ai-cyberattacks-google/

- Adversarial Misuse of Generative AI. (2025, January 29). Google Cloud Blog. https://cloud.google.com/blog/topics/threat-intelligence/adversarial-misuse-generative-ai

Deixe um comentário